이 과정에서 유념해야 할 기준

1. 이미지 사용 비용과 가용성: 비용은 이미지 품질에 따라 달라지고, 품질은 기사에 탐지가 필요한 대상의 유형에 따라 달라집니다. 예를 들어, 소 떼 탐지는 넓은 들판에서 농경지의 존재를 탐지하는 것보다 훨씬 더 세분화된 작업(이미지 레이블링)입니다.

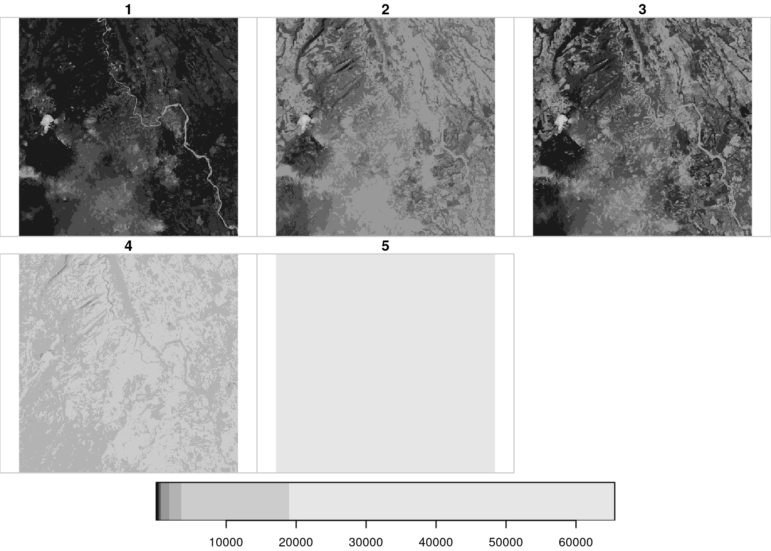

2. 이미지 저장 및 처리: 고품질의 위성 이미지는 100 제곱킬로미터 당 약 0.3GB의 용량은 되어야 합니다. 이 정도 고화질이 되려면 텍사스 주 면적의 경우 이미지 용량이 대략 2TB, 브라질 면적의 경우 최대 26TB는 되어야 한다는 뜻입니다. 따라서 지역을 제한하면 현실적인 저장 및 처리 능력을 확보할 수 있습니다. 특정 지역의 1년 전과 현재의 모습을 비교하는 등 변경 탐지 작업을 수행하려면 저장 용량을 두 배로 늘려야 합니다.

이런 응용 프로그램의 주된 제약 요소는 카운팅 (세는) 알고리즘 개발이 아니라 고해상도 이미지를 입수할 수 있느냐다. 또한, 위성 이미지로 특정 개인을 식별할 수 있으려면 현재 상업용 위성으로는 지원되지 않는 수준의 해상도가 필요하다. — 알프레도 칼라이치, <소를 세다> 프로젝트

적어도 한 나라에 대해서는 이미지를 확보하고 전체 알고리즘 처리가 실행되는 것을 볼 수 있기를 바라자. 그것이 불가능하다면, 더 큰 객체를 탐지하는 연구로 선회해서 무료로 사용할 수 있는 이미지를 활용하면 된다. — 플로르 코엘료, 프롬 어보브 팀

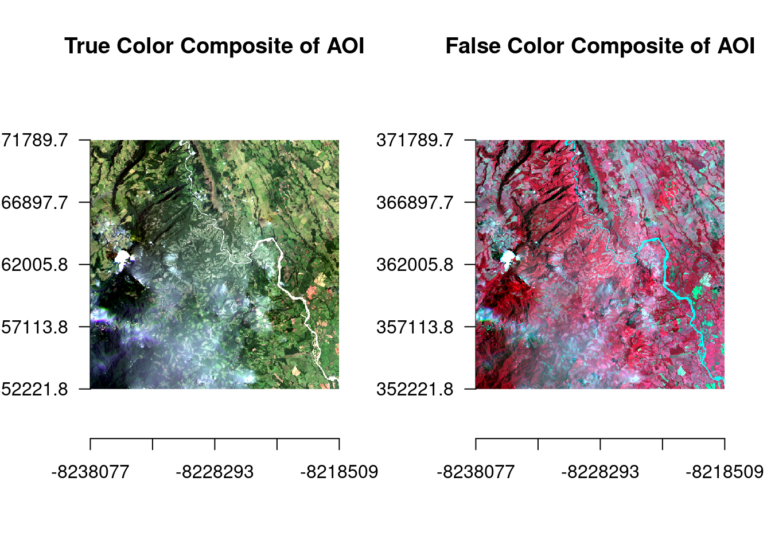

플래닛 NICFI 계정이 있다면 플래닛이 제공하는 ‘베이스맵 뷰어’(Basemaps Viewer) 서비스와 ‘익스플로러 온라인’(Explorer Online) 서비스의 차이점을 확인해보자. ‘베이스맵 뷰어’는 과거 이미지 여러 레이어가 포함된 좀 더 분석적인 위성 이미지 다운로드 서비스를 제공한다. ‘베이스맵’ 또는 타사의 위성 이미지 소스를 사용할 때 다운로드 가능한 시각적 합성 요소와 분석적 합성 요소를 명확하게 구분할 수 있어야 한다. ‘익스플로러 온라인’은 앞서 언급한 여러 대역으로 인코딩된다. ‘베이스맵’과 ‘익스플로러’는 거의 비슷해 보이지만, 데이터 처리와 데이터 추출 및 모델링을 위한 이미지는 ‘익스플로러 온라인’에서만 다운로드할 수 있다.

| 글 | 프롬어보브 팀 |

| 디자인 | 이도현 |

| 웹출판 | 허현재 |

| 번역, 감수 | 최시내, 김지윤 |

뉴스타파는 권력과 자본의 간섭을 받지 않고 진실만을 보도하기 위해, 광고나 협찬 없이 오직 후원회원들의 회비로만 제작됩니다. 월 1만원 후원으로 더 나은 세상을 만들어주세요.